Norm即Normalization,是对数据进行归一化的一种操作,一般是将数据归一化到“平均为0,方差为1”的分布中,RMS Norm相比Layer Norm少了一个除以平均数的步骤。

Layer Norm即是直接对层进行正则化,一般有两种,一个是事先正则化(pre norm),一个是事后正则化(post norm)。

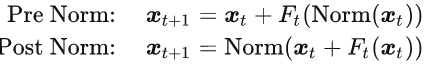

事先正则化就是直接对于输入进行正则化,然后再计算结果,事后正则化则是结果计算出来后,再统一进行正则化。

进一步的在LLAMA2中,则进一步改用了RMSNorm,不但效果不错,更重要的是进一步提高了计算效率。

1 comment so far